Videos de abuso sexual infantil generados por IA se dispararon en 2025 mientras Grok enfrenta una investigación

Los videos que muestran abuso sexual infantil generados por inteligencia artificial aumentaron más de un 26,000 % en 2025, en medio de la creciente preocupación por Grok, un chatbot de IA que ahora está bajo investigación por producir contenido similar. El fiscal general de California, Rob Bonta, ha anunciado una investigación oficial sobre Grok y su empresa matriz, xAI.

La Internet Watch Foundation (IWF), con sede en el Reino Unido, informó haber identificado 3,440 de estos videos generados por IA en 2025, un aumento considerable frente a los solo 13 del año anterior. Más de la mitad de los videos se clasificaron en la “categoría A”, la designación para las formas más graves de abuso, según informó CBS News.

[Estamos en WhatsApp. Empieza a seguirnos ahora]

El chatbot Grok, desarrollado por xAI de Elon Musk e integrado en la plataforma X, se convirtió en un foco de controversia en diciembre después de que Copyleaks, una empresa de detección de contenido, descubriera que generaba una imagen sexualizada no consentida por minuto, según sus estimaciones.

En respuesta, xAI declaró que había implementado cambios para impedir que los usuarios generaran imágenes de personas con poca ropa a través de Grok, tras el escrutinio de los reguladores de la Unión Europea y las agencias de protección al consumidor en Estados Unidos.

«Tomamos medidas para eliminar contenido infractor de alta prioridad, incluido el Material de Abuso Sexual Infantil (CSAM) y la desnudez no consentida, tomando las acciones apropiadas contra las cuentas que violan nuestras Reglas de X», se lee en un comunicado de la empresa. «También denunciamos a las autoridades policiales, según sea necesario, las cuentas que buscan materiales de Explotación Sexual Infantil».

«Hemos implementado medidas tecnológicas para evitar que la cuenta [@]Grok en X, a nivel mundial, permita la edición de imágenes de personas reales con ropa reveladora como bikinis. Esta restricción se aplica a todos los usuarios, incluidos los suscriptores de pago».

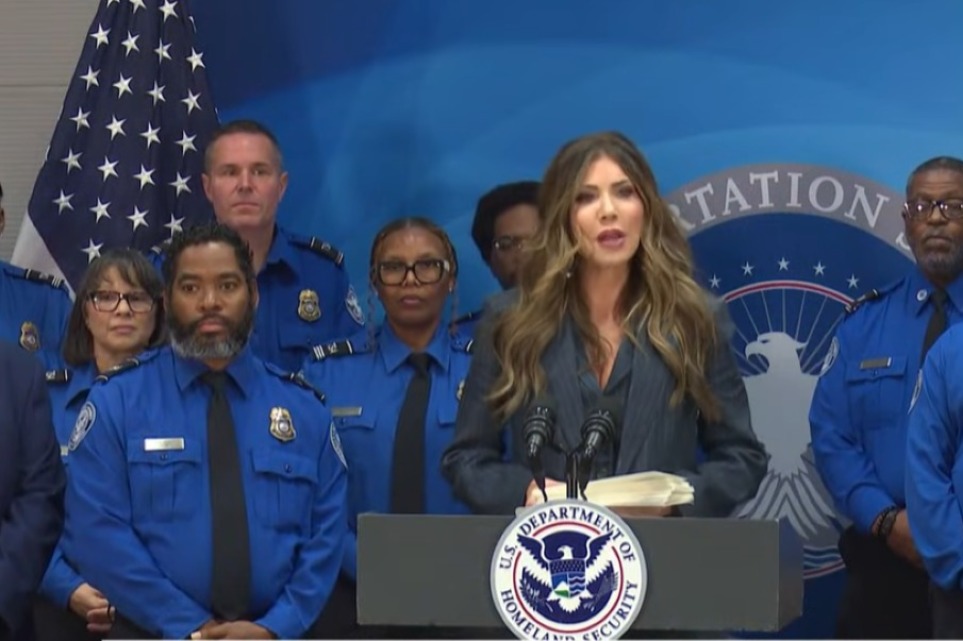

El Centro Nacional sobre Explotación Sexual (NCOSE, por sus siglas en inglés) envió una declaración a The Christian Post afirmando que Grok había creado decenas de miles de imágenes que sexualizaban a mujeres y niños sin su consentimiento. El grupo instó al Congreso a actuar rápidamente para regular las herramientas impulsadas por IA.

«Las imágenes deepfake sexualmente explícitas se utilizan para acosar, deshumanizar y silenciar a las personas, especialmente a las mujeres», dijo Dani Pinter, directora legal de NCOSE. «Si se permite que la tecnología de IA avance sin rendición de cuentas, no será una herramienta de innovación, sino un arma barata para el acoso y la humillación».

El grupo afirmó que Grok es el último de una serie de ejemplos que demuestran cómo las empresas tecnológicas se benefician de las herramientas que permiten la producción masiva de imágenes de explotación, y que las leyes existentes no han logrado proteger a los usuarios estadounidenses.

La organización expresó su apoyo a una serie de proyectos de ley federales que considera esenciales para frenar los abusos posibilitados por la IA, incluida la Ley DEFIANCE, que fue aprobada por el Senado la semana pasada y permitiría a los sobrevivientes de imágenes sexuales deepfake emprender acciones civiles contra los perpetradores.

El grupo también está presionando para que se aprueben la Ley de Seguridad Infantil en Línea (Kids Online Safety Act) y la Ley de Caducidad de la Sección 230 (Sunset Section 230 Act), que impondrían a las plataformas deberes legales para prevenir y mitigar los daños a menores y reducirían la inmunidad de la que gozan las empresas tecnológicas sobre el contenido generado por los usuarios.

Otros proyectos de ley citados por el grupo incluyen la Ley STOP CSAM, la Ley A.I. LEAD, la Ley GUARD, la Ley NO FAKES y la Ley de Reautorización de Prevención y Protección de Víctimas de Trata Frederick Douglass de 2025.

La IWF señaló que el material de abuso sexual infantil generado por IA que registró el año pasado formaba parte de un aumento más amplio de contenido dañino, con más de 300,000 informes de CSAM procesados por el grupo de vigilancia.

La ley federal en Estados Unidos tipifica la producción o distribución de material de abuso sexual infantil como un delito penal bajo los estatutos que prohíben la pornografía infantil.

La IWF afirmó que las herramientas de IA más recientes son especialmente preocupantes porque permiten la generación de videos realistas a gran escala, con poca habilidad técnica, y a menudo combinando imágenes reales de niños extraídas de internet.

Los analistas del grupo dijeron que creen que el aumento de los incidentes refleja la creciente accesibilidad de las herramientas de IA para fines maliciosos.